说明

AI加速卡的资源调度主要是通过k8s device-plugin方式实现。与NVIDIA GPU资源调度的最大不同是,通用调度方法只支持 按卡 级别调度,而NVIDIA GPU支持按照 显存 大小来调度。

通用资源调度方法支持NVIDIA Jetson、比特大陆1684、华为昇腾310、寒武纪MLU270、百度昆仑XPU等。

操作指南

节点创建

- 针对这几种 AI加速卡,需要在创建节点时选择对应的加速卡,如下图所示:

调度组件安装

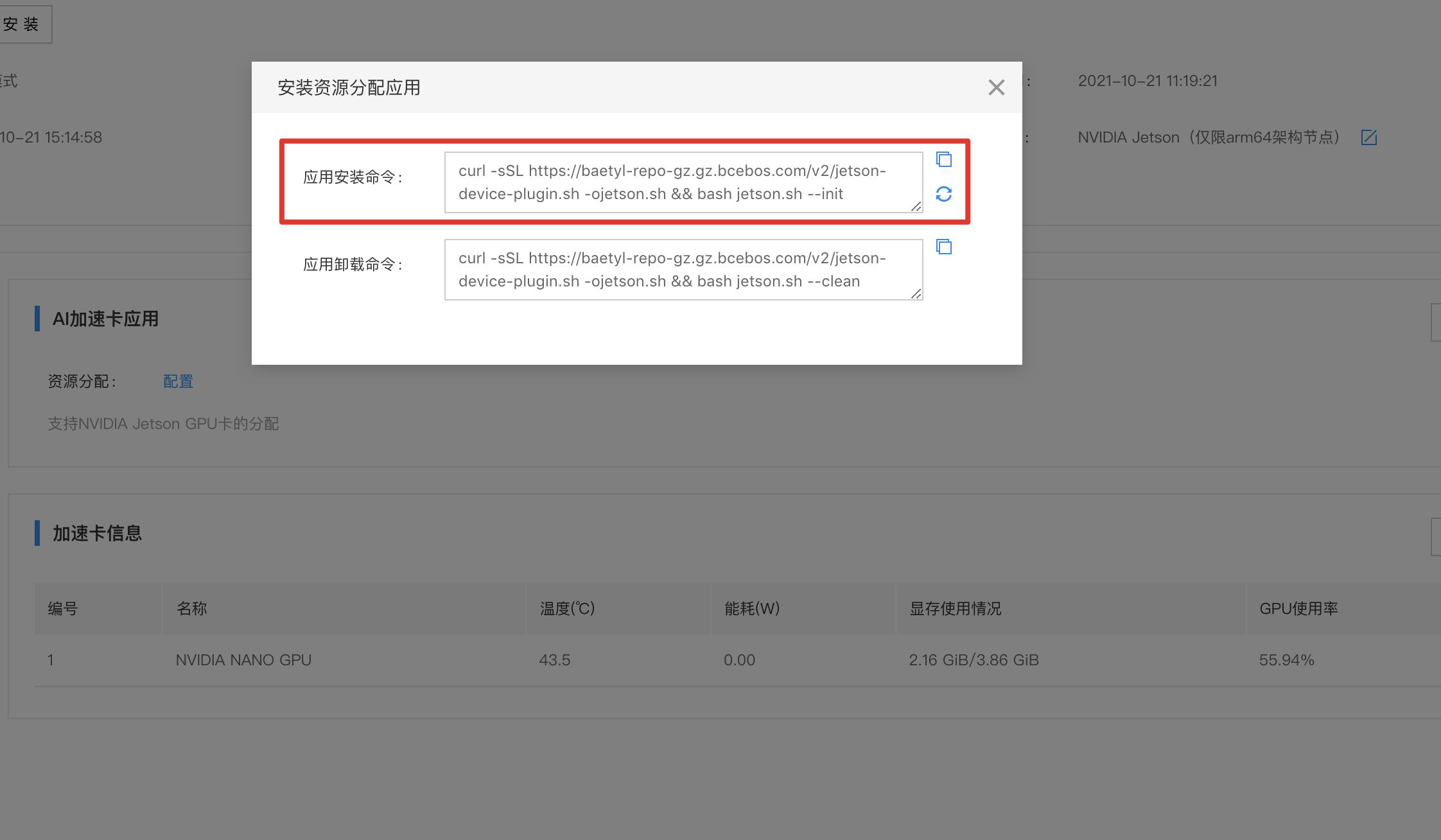

- 以Jetson为例,在创建节点时选择了NVIDIA Jetson加速卡,在节点的详情页,查看【AI加速卡】子菜单。

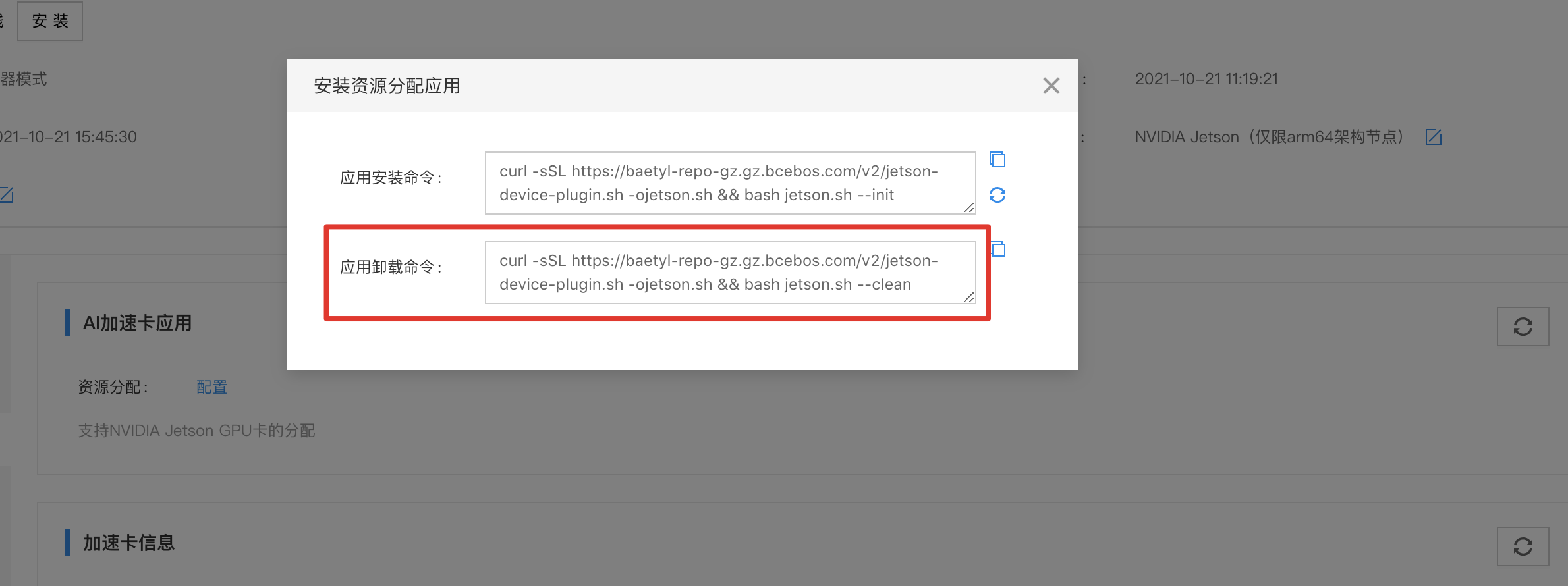

- 点击【配置】弹出弹出对话框,复制应用安装命令,在边缘节点上执行,用于安装AI加速卡调度插件。

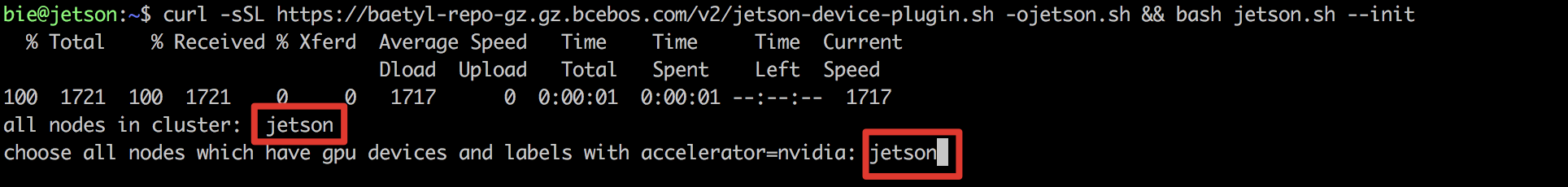

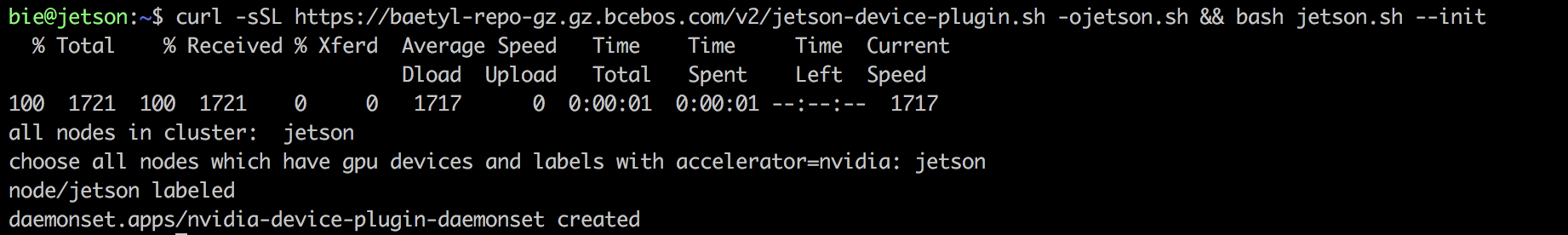

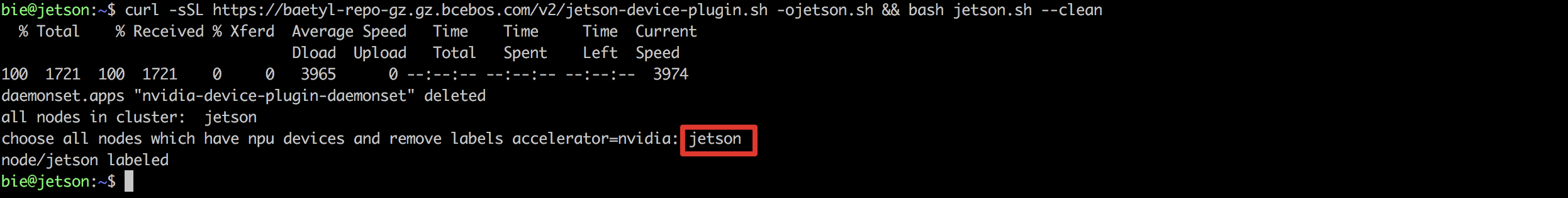

- 执行过程中会列出当前集群节点,需要输入节点确认。在这里只有一个节点jetson,输入jetson并回车即可。

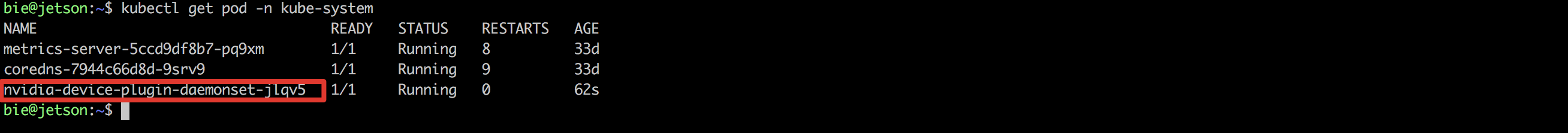

- 安装完成后,可以执行kubectl get pod -n kube-system,查看资源分配组件已运行。

- 卸载资源分配组件是类似的流程。点击【配置】弹出对话框,复制应用卸载命令,在边缘节点上执行。输入当前节点jetson回车即可完成应用卸载。

- 比特大陆1684、昇腾310的资源分配组件安装过程和jetson安装过程一致,此处不再赘述。

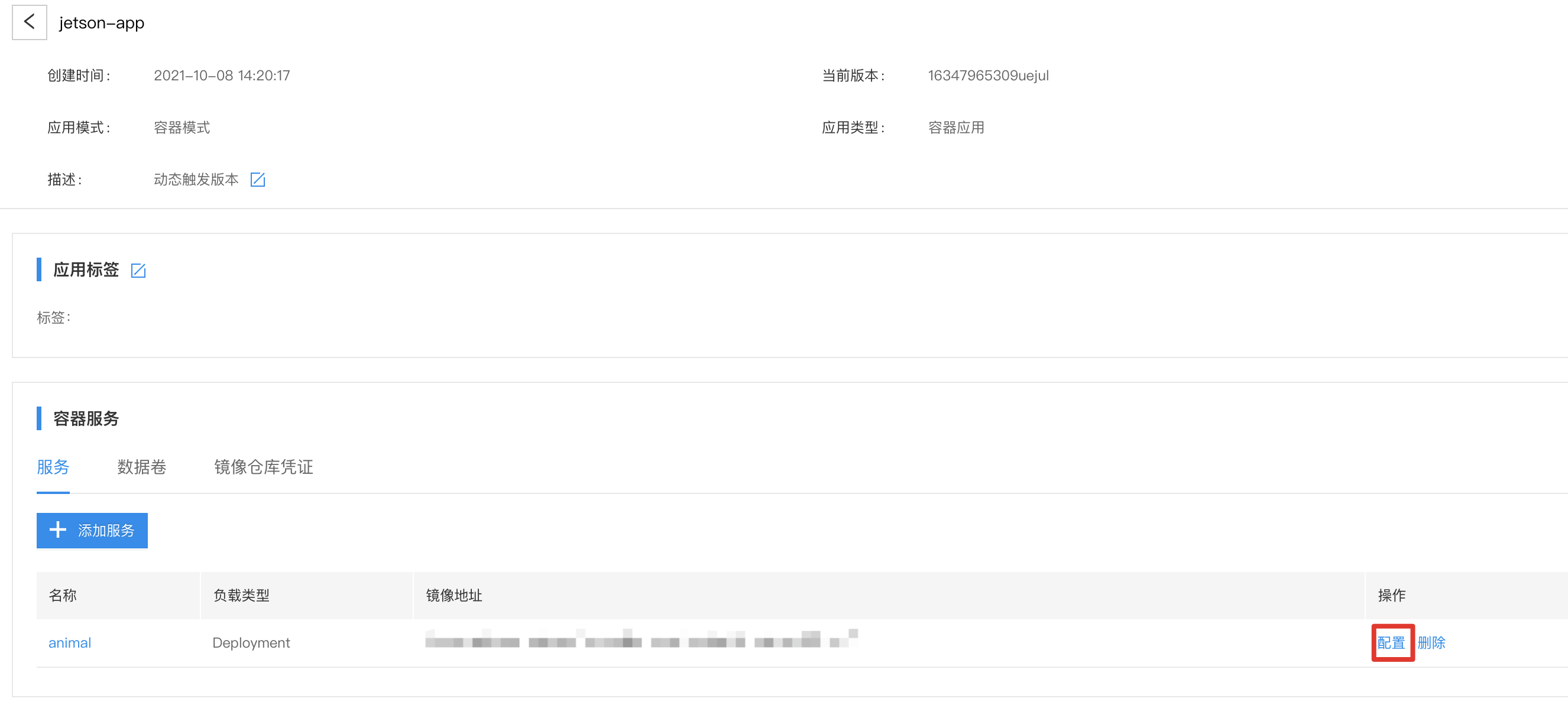

资源调度

- 安装好 AI加速卡资源调度组件 后,在节点关联的应用中可以配置AI加速卡资源。在应用服务配置中,选择高级配置:

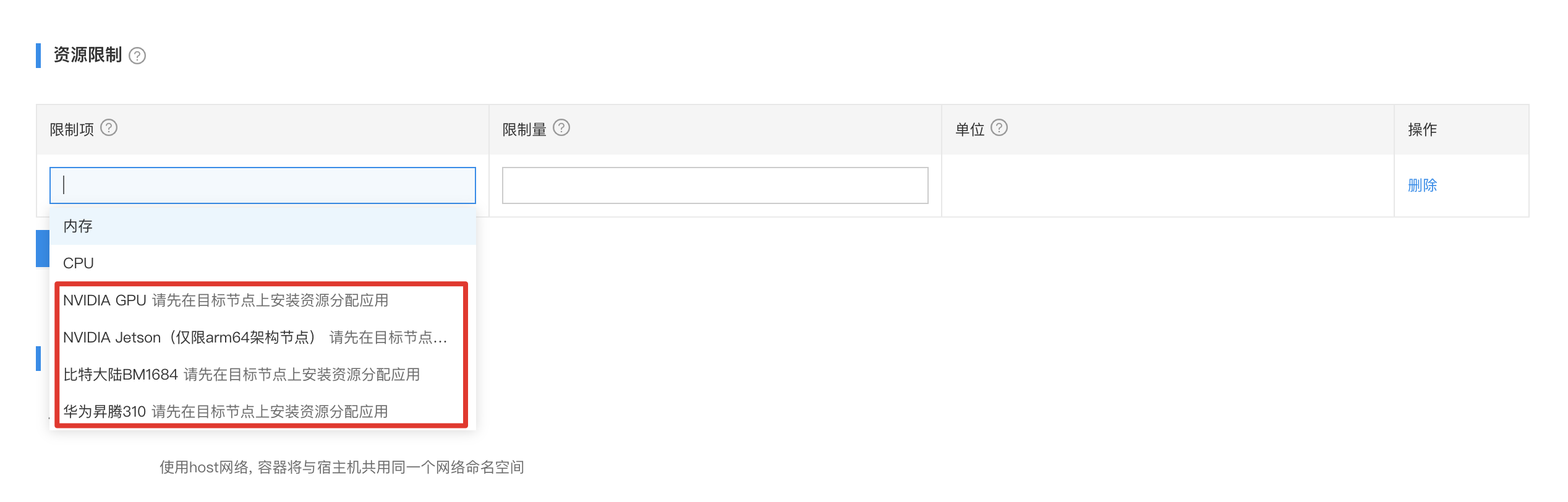

- 点击添加资源限制:

- 分配AI加速卡资源仅支持 >=1 的整数,且不能超过边缘节点的所有GPU数量。如配置了超过边缘节点的GPU数量,应用无法启动。配置完资源限制后,点击【确定】即可在边缘应用生效。

比特大陆1684不支持配置数量,数值只可为1。