百度智能云智能边缘 - 将物体检测模型部署至边缘

文档简介:

本文介绍如何在AI中台的模型中心导入原始模型,然后通过模型转换,生成适配通用X86芯片/通用ARM芯片的物体检测模型,并部署至设备边缘。

一、前提条件:

有一个可测试的边缘节点设备。

边缘节点连接至云端管控控制台,边缘节点安装可以参考快速入门。

本文介绍如何在AI中台的模型中心导入原始模型,然后通过模型转换,生成适配通用X86芯片/通用ARM芯片的物体检测模型,并部署至设备边缘。

一、前提条件

- 有一个可测试的边缘节点设备

- 边缘节点连接至云端管控控制台,边缘节点安装可以参考快速入门

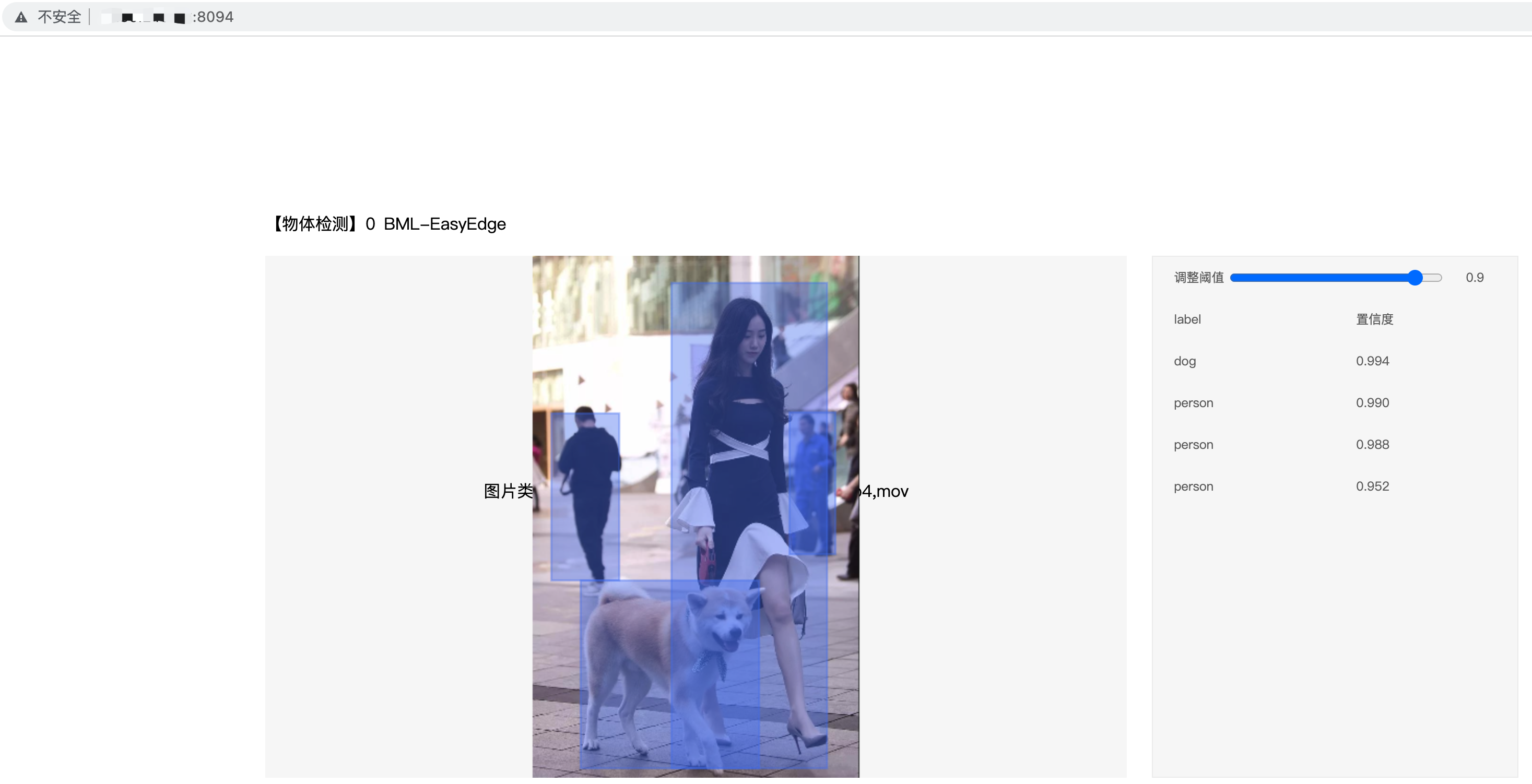

- 有一个物体检测模型,本实验用的是一个物体检测-Object_Detection_Paddle15_MobileNetV1_SSD。该模型支持检测人、狗、车等常见类型物体,如下图所示:

二、导入模型

打开AI中台控制台,进入模型中心,选中模型管理,如下图所示:

点击导入模型,将提前装备好的模型上传。

基础信息

基础信息

- 导入方式:导入新的模型

- 模型名称:object_detection

- 模型版本:1.0.0.0

模型配置信息

- 构建来源:模型文件构建

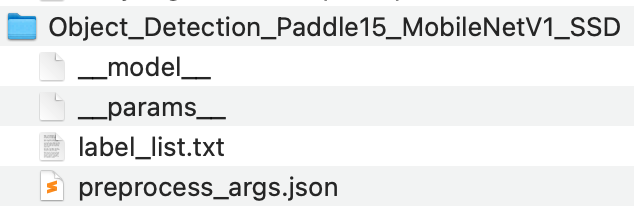

- 选择模型:本地上传,上传模型文件:Object_Detection_Paddle15_MobileNetV1_SSD.zip

- 模型类型:物体检测

- 模型框架:PaddlePaddle/1.5.0

- 网络结构:SSD/MobileNetV1-SSD

- 服务框架:ModelServer

- 模型参数文件名:__params__,前后双下划线,与压缩包当中的文件名称一致

- 模型文件名:__model__,前后双下划线,与压缩包当中的文件名称一致

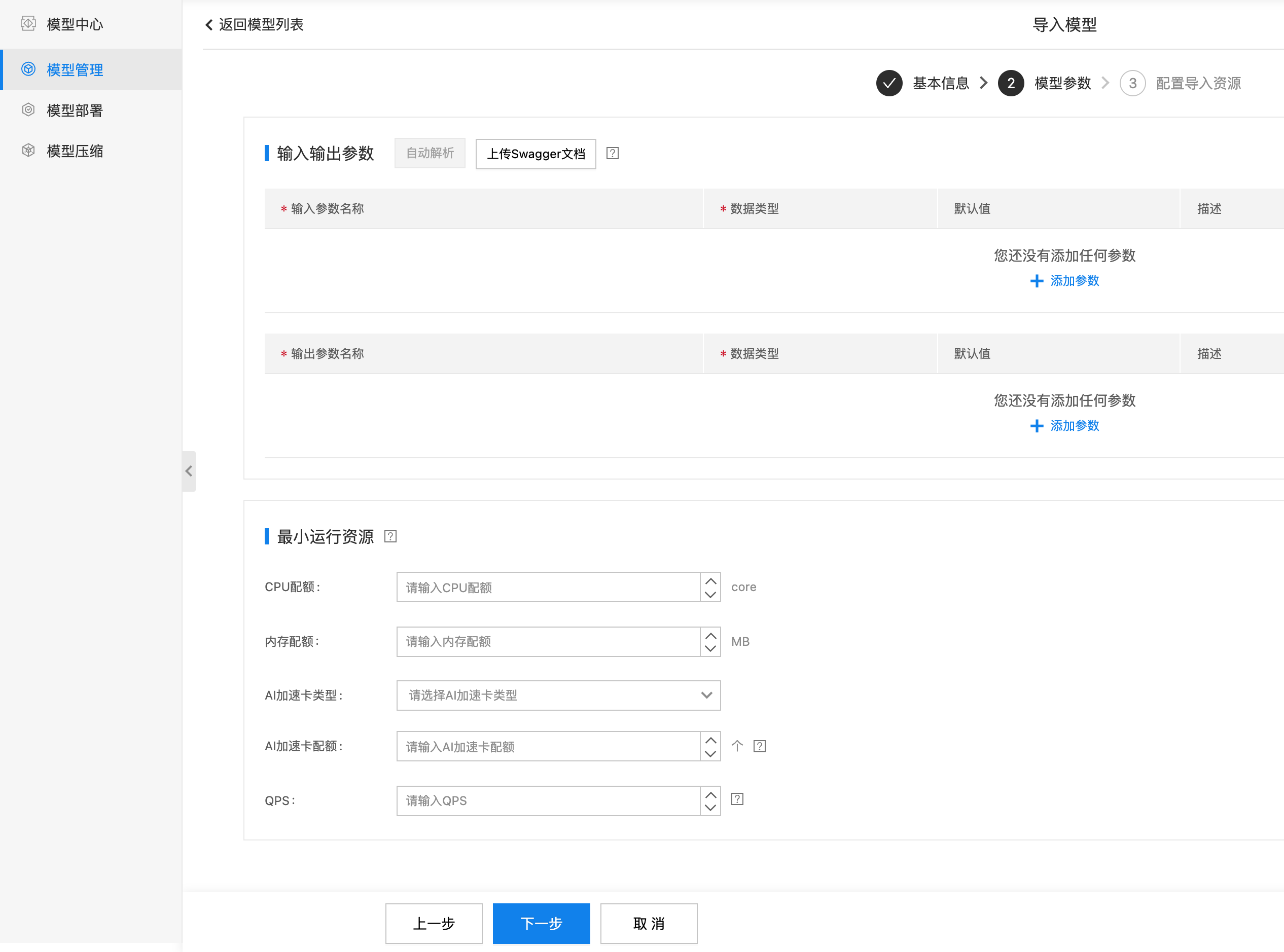

模型参数

模型参数使用默认值,为空即可,如下图所示:

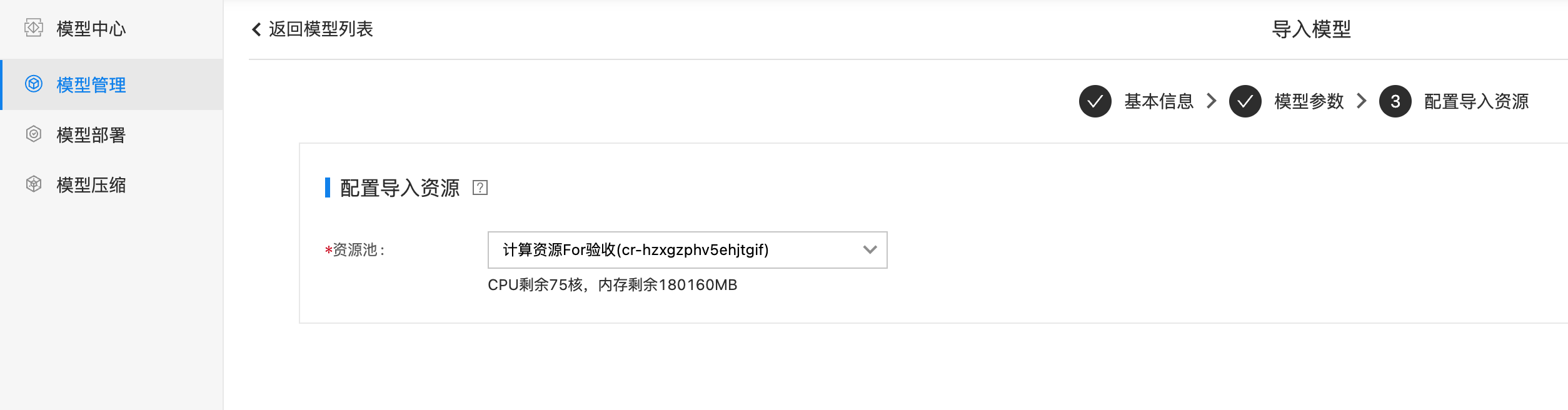

配置导入资源

资源池使用一个可用的资源池即可,如下图所示:

检查导入模型

导入完毕以后,返回模型中心,可以看到之前导入的模型,如下图所示:

模型状态为就绪,描述模型导入构建完毕:

三、边缘部署

- 在模型详情界面,下拉至部署信息,找到边缘部署,如下图所示:

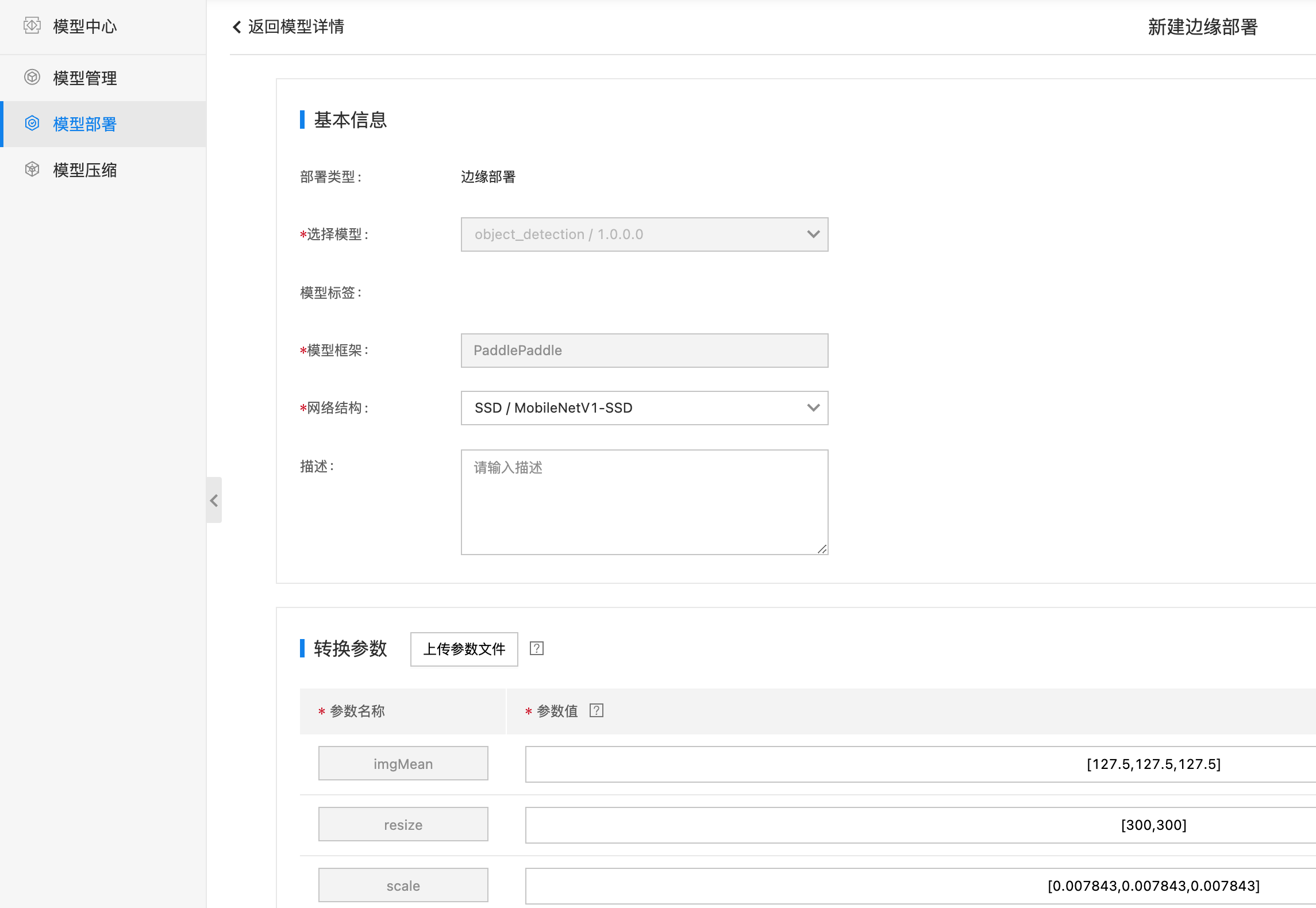

- 点击边缘部署,进入到模型部署-边缘部署界面,如下图所示:

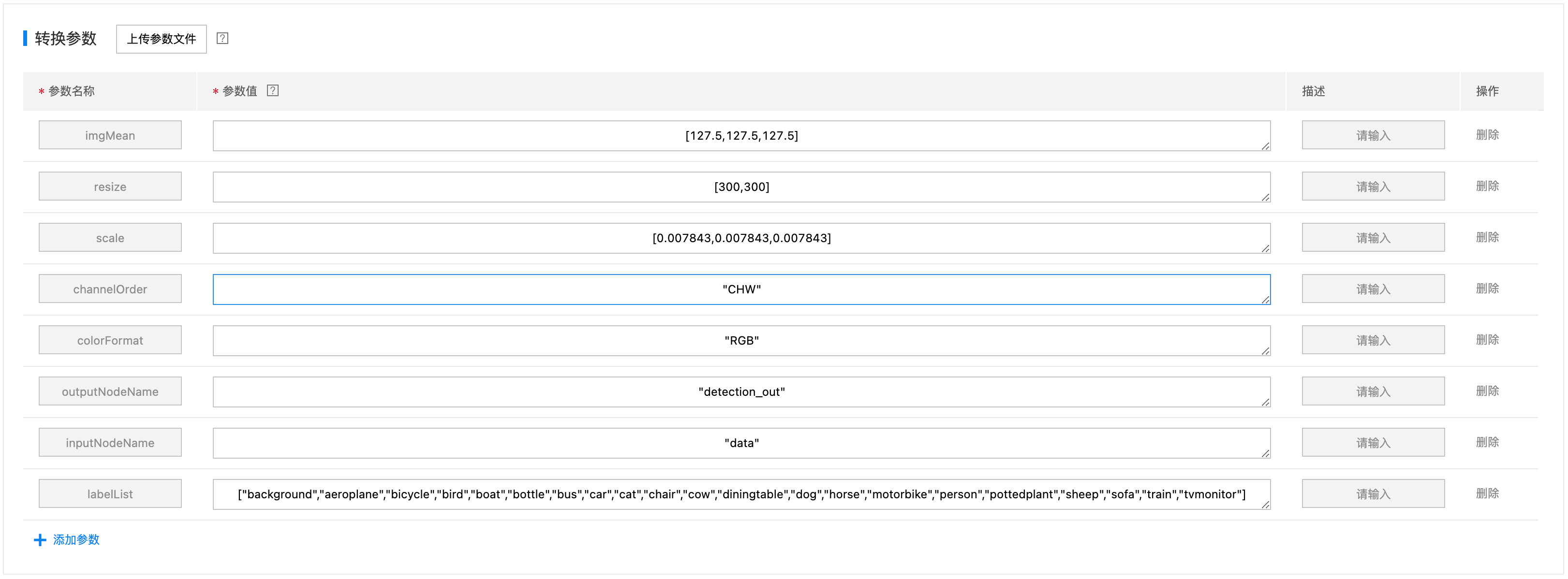

- 找到转换参数,点击上传参数文件,选择模型压缩包当中的preprocessor.json参数文件,如下图所示

4.找到边缘配置,选择目标节点,如下图所示:

- 选择节点:从下拉框当中选择一个可用的边缘节点,要求边缘节点在线才可以被选中,选中节点以后,自动展示这个节点所对应的硬件架构(amd64、arm64)和操作系统(linux)。边缘安装请参考快速入门。

- 硬件/芯片类型:因为上述节点上报的是amd64架构,所以这里只能选择 通用X86芯片,如果节点上报的架构是ARM64架构,则此处只能选择 通用ARM芯片

- 操作系统:因为上述节点上报的是linux操作系统,所以这里只能选择linux

- 端口:设置AI服务映射到宿主机的端口。可以点击【查询已占用端口】来查看当前已经使用的端口号,避免端口冲突。

- 其他部署配置:这里设置的KV配置,对应BIE边缘应用配置当中的服务环境变量。

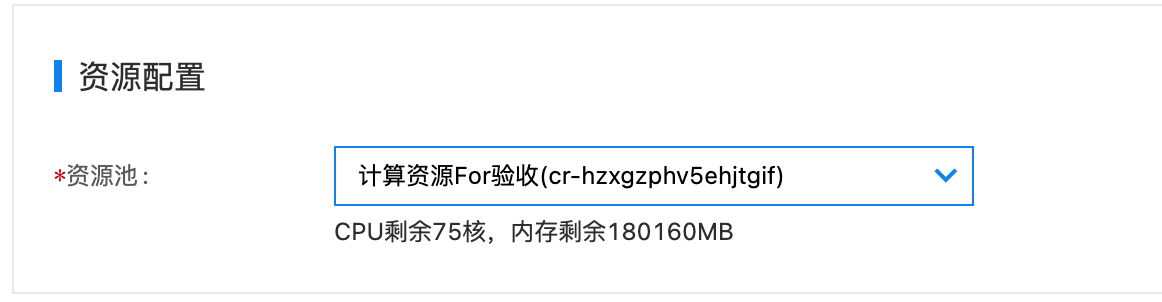

- 在资源配置当中,选择可以的资源池,如下图所示:

四、验证

- 在模型部署——> 边缘部署 列表下,找到刚才创建的边缘部署任务testmodel,如下图所以:

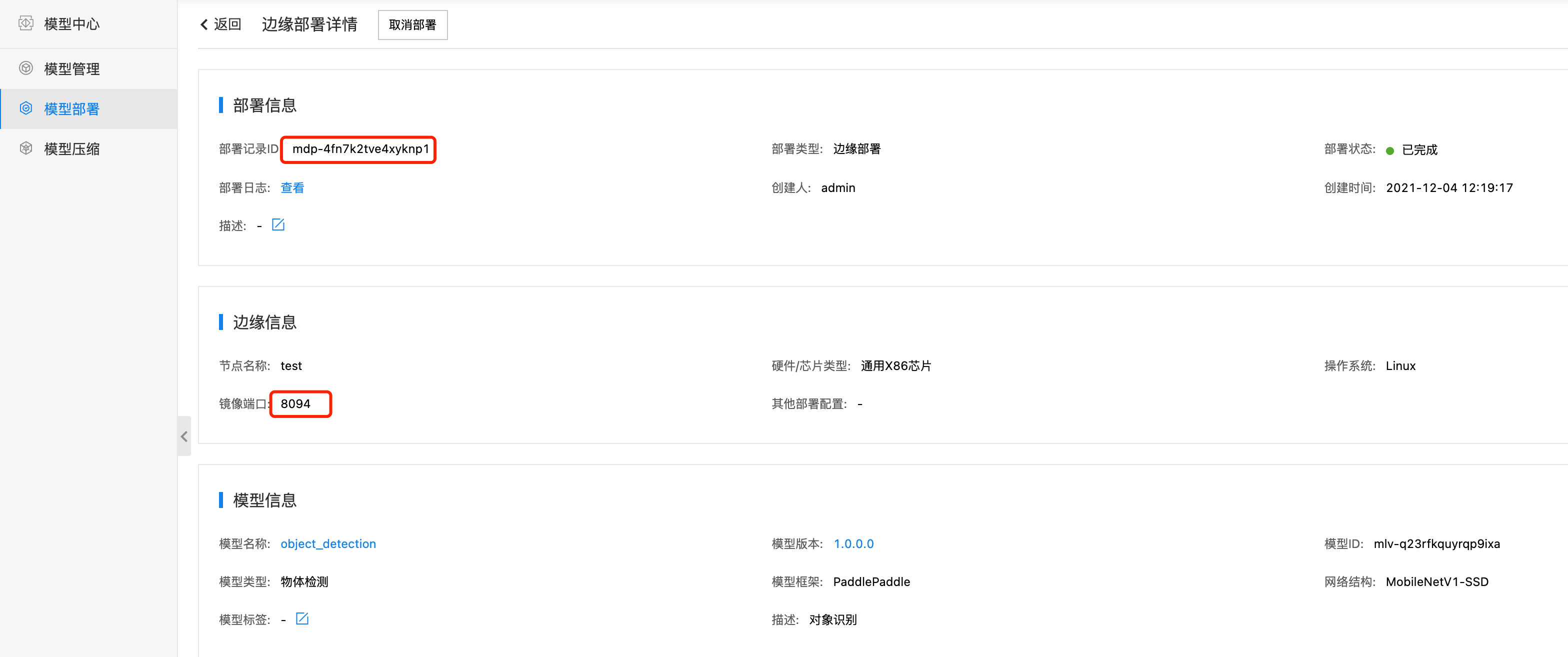

- 我们可以看到边缘部署状态是已完成。点击右边的详情按钮,查看部署详情,如下图所示:

- 节点:test

- 端口:8094

- 部署记录ID: mdp-4fn7k2tve4xyknp1

- 打开智能边缘界面,找到test节点,查看mdp-4fn7k2tve4xyknp1应用的部署状态,如下图所示:

可以看到,在智能边缘界面,确实创建了mdp-4fn7k2tve4xyknp1应用,并部署到了test节点上,并且状态已经是已部署。

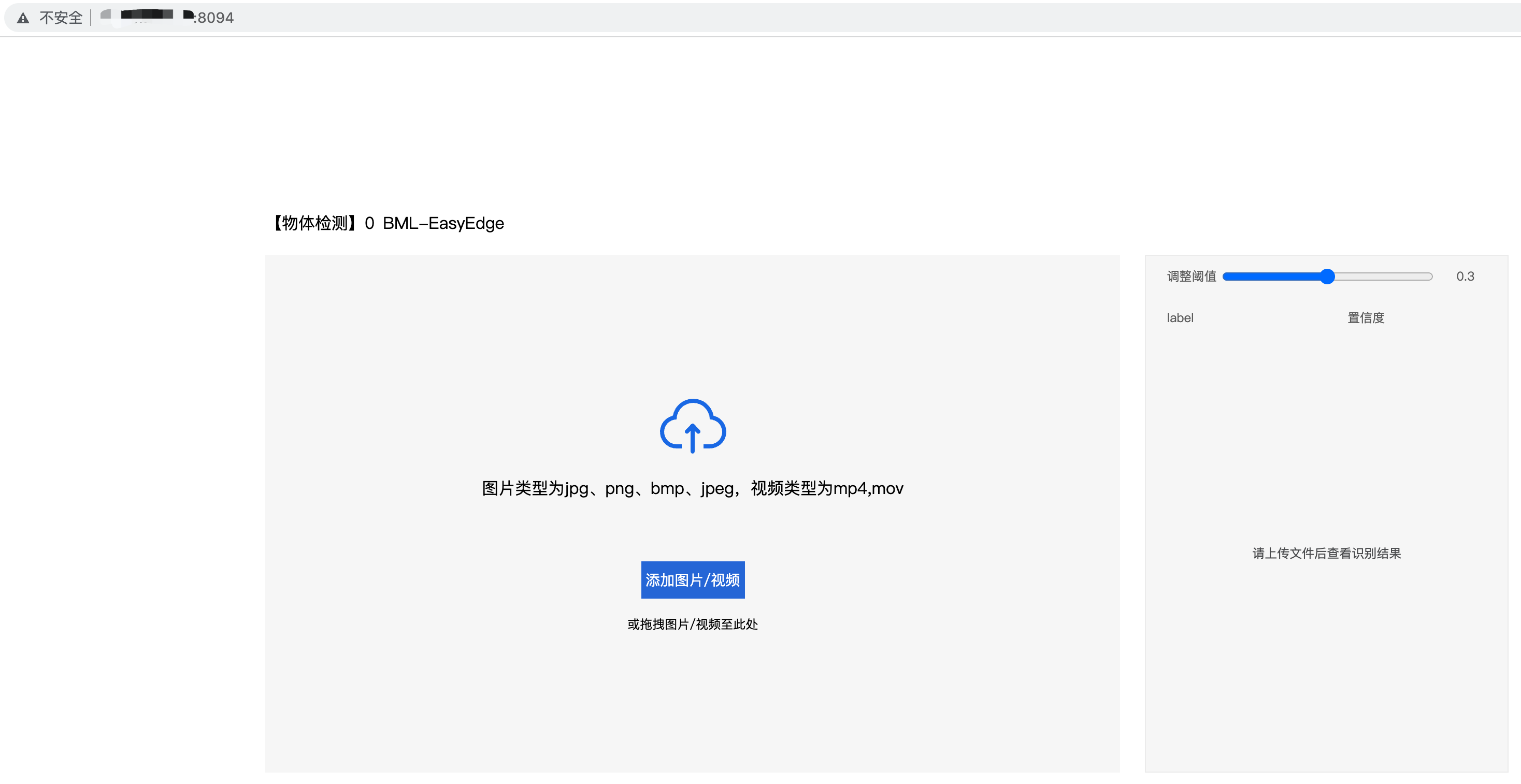

- 打开浏览器,输入[边缘节点ip:8094],验证边缘服务是否正常启动,如下图所示:

- 可以看到边缘AI服务已经正常启动,点击添加图片按钮,上传一张测试图片,查看推断结果,如下所示: