文档简介:

#加载飞桨和相关类库 import paddle from paddle.nn import Linear import paddle.nn.functional

as F import os import numpy as np import matplotlib.pyplot as plt

/opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/matplotlib/__ini

t__.py:107: DeprecationWarning: Using or importing the ABCs from 'collections' instead of from

'collections.abc' is deprecated, and in 3.8 it will stop working from collections import MutableMapping /opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/matplotlib/rcsetup.py:20

: DeprecationWarning: Using or importing the ABCs from 'collections' instead of from

'collections.abc' is deprecated, and in 3.8 it will stop working from collections import Iterable, Mapping /opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/matplotlib/colors.py:53:

DeprecationWarning: Using or importing the ABCs from 'collections' instead of from '

collections.abc' is deprecated, and in 3.8 it will stop working from collections import Sized

# 设置数据读取器,API自动读取MNIST数据训练集 train_dataset = paddle.vision.datasets.MNIST(mode='train')

通过如下代码读取任意一个数据内容,观察打印结果。

train_data0 = np.array(train_dataset[0][0])

train_label_0 = np.array(train_dataset[0][1]) # 显示第一batch的第一个图像 import matplotlib.pyplot as plt

plt.figure("Image") # 图像窗口名称 plt.figure(figsize=(2,2))

plt.imshow(train_data0, cmap=plt.cm.binary)

plt.axis('on') # 关掉坐标轴为 off plt.title('image') # 图像题目 plt.show()

print("图像数据形状和对应数据为:", train_data0.shape)

print("图像标签形状和对应数据为:", train_label_0.shape, train_label_0)

print("\n打印第一个batch的第一个图像,对应标签数字为{}".format(train_label_0))

/opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/matplotlib/cbook

/__init__.py:2349: DeprecationWarning: Using or importing the ABCs from 'collections'

instead of from 'collections.abc' is deprecated, and in 3.8 it will stop working if isinstance(obj, collections.Iterator): /opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/matplotlib/cbook/

__init__.py:2366: DeprecationWarning: Using or importing the ABCs from 'collections'

instead of from 'collections.abc' is deprecated, and in 3.8 it will stop working return list(data) if isinstance(data, collections.MappingView) else data /opt/conda/envs/python35-paddle120-env/lib/python3.7/site-packages/numpy/lib/type_

check.py:546: DeprecationWarning: np.asscalar(a) is deprecated since NumPy v1.16, use a.item() instead 'a.item() instead', DeprecationWarning, stacklevel=1)

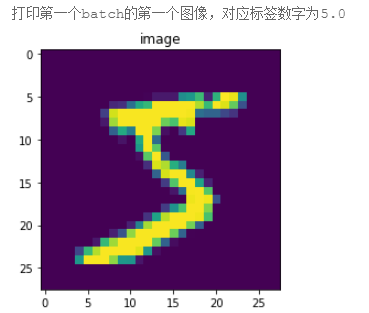

图像数据形状和对应数据为: (28, 28) 图像标签形状和对应数据为: (1,) [5] 打印第一个batch的第一个图像,对应标签数字为[5]

使用matplotlib工具包将其显示出来,如图2 所示。可以看到图片显示的数字是5,和对应标签数字一致。

图2:matplotlib打印结果示意图

说明:

飞桨将维度是28×28的手写数字图像转成向量形式存储,因此使用飞桨数据加载器读取到的手写数字图像是长度为784(28×28)的向量。

飞桨API的使用方法

熟练掌握飞桨API的使用方法,是使用飞桨完成各类深度学习任务的基础,也是开发者必须掌握的技能。

飞桨API文档获取方式及目录结构

登录“飞桨官网->文档->API文档”,可以获取飞桨API文档。在飞桨最新的版本中,对API做了许多优化,目录结构与说明,如 图3 所示。

图3:飞桨API文档目录

API文档使用方法

飞桨每个API的文档结构一致,包含接口形式、功能说明和计算公式、参数和返回值、代码示例四个部分。 以Relu函数为例,API文档结构如 图4 所示。通过飞桨API文档,读者不仅可以详细查看函数功能,还可以通过可运行的代码示例来实践API的使用。

图4:Relu的API文档

模型设计

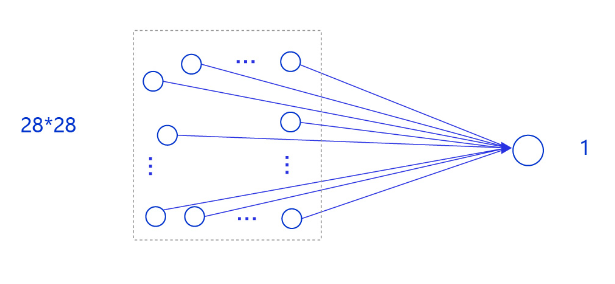

在房价预测深度学习任务中,我们使用了单层且没有非线性变换的模型,取得了理想的预测效果。在手写数字识别中,我们依然使用这个模型预测输入的图形数字值。其中,模型的输入为784维(28×28)数据,输出为1维数据,如 图5 所示。

图5:手写数字识别网络模型

输入像素的位置排布信息对理解图像内容非常重要(如将原始尺寸为28×28图像的像素按照7×112的尺寸排布,那么其中的数字将不可识别),因此网络的输入设计为28×28的尺寸,而不是1×784,以便于模型能够正确处理像素之间的空间信息。

说明:

事实上,采用只有一层的简单网络(对输入求加权和)时并没有处理位置关系信息,因此可以猜测出此模型的预测效果可能有限。在后续优化环节介绍的卷积神经网络则更好的考虑了这种位置关系信息,模型的预测效果也会有显著提升。

下面以类的方式组建手写数字识别的网络,实现方法如下所示。

# 定义mnist数据识别网络结构,同房价预测网络 class MNIST(paddle.nn.Layer): def __init__(self)

: super(MNIST, self).__init__() # 定义一层全连接层,输出维度是1 self.fc = paddle.nn.Linear

(in_features=784, out_features=1) # 定义网络结构的前向计算过程 def forward(self, inputs):

outputs = self.fc(inputs) return outputs

# 声明网络结构 model = MNIST() def train(model): # 启动训练模式 model.train() # 加载训练集

batch_size 设为 16 train_loader = paddle.io.DataLoader(paddle.vision.datasets.MNIST(mode='train'),

batch_size=16,

shuffle=True) # 定义优化器,使用随机梯度下降SGD优化器,

学习率设置为0.001 opt = paddle.optimizer.SGD(learning_rate=0.001, parameters=model.parameters())

# 图像归一化函数,将数据范围为[0, 255]的图像归一化到[0, 1] def norm_img(img):

# 验证传入数据格式是否正确,img的shape为[batch_size, 28, 28] assert len(img.shape)

== 3 batch_size, img_h, img_w = img.shape[0], img.shape[1], img.shape[2] #

归一化图像数据 img = img / 255 # 将图像形式reshape为[batch_size, 784]

img = paddle.reshape(img, [batch_size, img_h*img_w]) return img

import paddle # 确保从paddle.vision.datasets.MNIST中加载的图像数据是np.ndarray类型

paddle.vision.set_image_backend('cv2') # 声明网络结构 model = MNIST() def train(model):

# 启动训练模式 model.train() # 加载训练集 batch_size 设为 16 train_loader = paddle.io.

DataLoader(paddle.vision.datasets.MNIST(mode='train'),

batch_size=16,

shuffle=True) # 定义优化器,使用随机梯度下降SGD优化器,

学习率设置为0.001 opt = paddle.optimizer.SGD(learning_rate=0.001, parameters=model.parameters())

EPOCH_NUM = 10 for epoch in range(EPOCH_NUM): for batch_id, data in enumerate(train_loader()):

images = norm_img(data[0]).astype('float32')

labels = data[1].astype('float32') #前向计算的过程 predicts = model(images)

# 计算损失 loss = F.square_error_cost(predicts, labels)

avg_loss = paddle.mean(loss) #每训练了1000批次的数据,打印下当前Loss的情况

if batch_id % 1000 == 0:

print("epoch_id: {}, batch_id: {}, loss is: {}".format(epoch, batch_id,

avg_loss.numpy())) #后向传播,更新参数的过程 avg_loss.backward()

opt.step()

opt.clear_grad()

train(model)

paddle.save(model.state_dict(), './mnist.pdparams')

epoch_id: 0, batch_id: 0, loss is: [35.525185] epoch_id: 0, batch_id: 1000, loss is: [7.4399786] epoch_id: 0, batch_id: 2000, loss is: [2.0210705] epoch_id: 0, batch_id: 3000, loss is: [2.325027] epoch_id: 1, batch_id: 0, loss is: [2.4414306] epoch_id: 1, batch_id: 1000, loss is: [4.6318164] epoch_id: 1, batch_id: 2000, loss is: [4.6807127] epoch_id: 1, batch_id: 3000, loss is: [5.7014084] epoch_id: 2, batch_id: 0, loss is: [3.4229655] epoch_id: 2, batch_id: 1000, loss is: [2.1136832] epoch_id: 2, batch_id: 2000, loss is: [2.3517294] epoch_id: 2, batch_id: 3000, loss is: [6.7515297] epoch_id: 3, batch_id: 0, loss is: [4.119179] epoch_id: 3, batch_id: 1000, loss is: [4.4800296] epoch_id: 3, batch_id: 2000, loss is: [3.4902763] epoch_id: 3, batch_id: 3000, loss is: [3.631486] epoch_id: 4, batch_id: 0, loss is: [6.123066] epoch_id: 4, batch_id: 1000, loss is: [2.8558893] epoch_id: 4, batch_id: 2000, loss is: [2.6112337] epoch_id: 4, batch_id: 3000, loss is: [2.0097098] epoch_id: 5, batch_id: 0, loss is: [3.9023933] epoch_id: 5, batch_id: 1000, loss is: [2.1165676] epoch_id: 5, batch_id: 2000, loss is: [3.2067215] epoch_id: 5, batch_id: 3000, loss is: [2.4574804] epoch_id: 6, batch_id: 0, loss is: [1.8463242] epoch_id: 6, batch_id: 1000, loss is: [3.4741895] epoch_id: 6, batch_id: 2000, loss is: [2.057652] epoch_id: 6, batch_id: 3000, loss is: [2.0860665] epoch_id: 7, batch_id: 0, loss is: [3.90655] epoch_id: 7, batch_id: 1000, loss is: [2.5527935] epoch_id: 7, batch_id: 2000, loss is: [3.239427] epoch_id: 7, batch_id: 3000, loss is: [6.7344103] epoch_id: 8, batch_id: 0, loss is: [1.6209174] epoch_id: 8, batch_id: 1000, loss is: [2.686802] epoch_id: 8, batch_id: 2000, loss is: [7.759363] epoch_id: 8, batch_id: 3000, loss is: [3.1380877] epoch_id: 9, batch_id: 0, loss is: [3.1067057] epoch_id: 9, batch_id: 1000, loss is: [2.864774] epoch_id: 9, batch_id: 2000, loss is: [2.528369] epoch_id: 9, batch_id: 3000, loss is: [4.1854725]

另外,从训练过程中损失所发生的变化可以发现,虽然损失整体上在降低,但到训练的最后一轮,损失函数值依然较高。可以猜测手写数字识别完全复用房价预测的代码,训练效果并不好。接下来我们通过模型测试,获取模型训练的真实效果。

模型测试

模型测试的主要目的是验证训练好的模型是否能正确识别出数字,包括如下四步:

- 声明实例

- 加载模型:加载训练过程中保存的模型参数,

- 灌入数据:将测试样本传入模型,模型的状态设置为校验状态(eval),显式告诉框架我们接下来只会使用前向计算的流程,不会计算梯度和梯度反向传播。

- 获取预测结果,取整后作为预测标签输出。

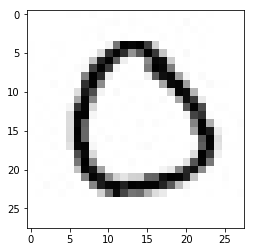

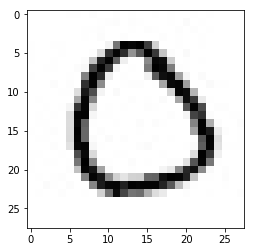

在模型测试之前,需要先从’./work/example_0.png’文件中读取样例图片,并进行归一化处理。

# 导入图像读取第三方库 import matplotlib.pyplot as plt import numpy as np from PIL import Image

img_path = './work/example_0.jpg' # 读取原始图像并显示 im = Image.open('./work/example_0.jpg')

plt.imshow(im)

plt.show() # 将原始图像转为灰度图 im = im.convert('L')

print('原始图像shape: ', np.array(im).shape) # 使用Image.ANTIALIAS方式采样原始图片 im = im.resize((28, 28), Image.ANTIALIAS)

plt.imshow(im)

plt.show()

print("采样后图片shape: ", np.array(im).shape)

原始图像shape: (28, 28)

采样后图片shape: (28, 28)

# 读取一张本地的样例图片,转变成模型输入的格式 def load_image(img_path): # 从img_path中读取图像,

并转为灰度图 im = Image.open(img_path).convert('L') # print(np.array(im)) im = im.resize((28, 28), Image.ANTIALIAS)

im = np.array(im).reshape(1, -1).astype(np.float32) # 图像归一化,保持和数据集的数据范围一致

im = 1 - im / 255 return im # 定义预测过程 model = MNIST()

params_file_path = 'mnist.pdparams' img_path = './work/example_0.jpg'

# 加载模型参数 param_dict = paddle.load(params_file_path)

model.load_dict(param_dict) # 灌入数据 model.eval()

tensor_img = load_image(img_path)

result = model(paddle.to_tensor(tensor_img))

print('result',result) # 预测输出取整,即为预测的数字,打印结果 print("本次预测的数字是", result.numpy().astype('int32'))

result Tensor(shape=[1, 1], dtype=float32, place=CPUPlace, stop_gradient=False,

[[1.11405170]])

本次预测的数字是 [[1]]

从打印结果来看,模型预测出的数字是与实际输出的图片的数字不一致。这里只是验证了一个样本的情况,如果我们尝试更多的样本,可发现许多数字图片识别结果是错误的。因此完全复用房价预测的实验并不适用于手写数字识别任务!

接下来我们会对手写数字识别实验模型进行逐一改进,直到获得令人满意的结果。